Di pusat setiap kekaisaran adalah ideologi, sistem kepercayaan yang mendorong sistem ke depan dan membenarkan ekspansi – bahkan jika biaya ekspansi itu secara langsung menentang misi yang dinyatakan ideologi.

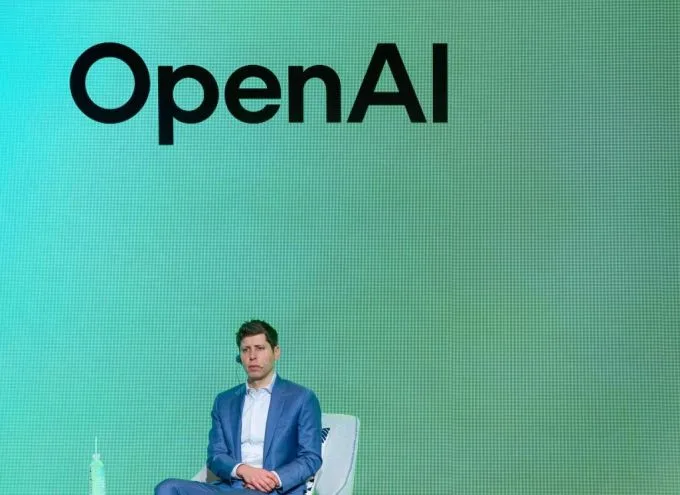

Untuk kekuatan kolonial Eropa, itu adalah agama Kristen dan janji menyelamatkan jiwa sambil mengekstraksi sumber daya. Untuk Kekaisaran AI saat ini, kecerdasan umum buatan untuk “menguntungkan semua kemanusiaan.” Dan Openai adalah penginjil utamanya, menyebarkan semangat di seluruh industri dengan cara yang telah membingkai ulang bagaimana AI dibangun.

“Saya sedang mewawancarai orang -orang yang suaranya bergetar dari semangat keyakinan mereka di Agi,” Karen Hao, jurnalis dan penulis terlaris dari “Kekaisaran AI”Kata TechCrunch pada episode Equity baru -baru ini.

Dalam bukunya, Hao menyamakan industri AI secara umum, dan Openai pada khususnya, dengan sebuah kerajaan.

“Satu -satunya cara untuk benar -benar memahami ruang lingkup dan skala perilaku Openai … sebenarnya untuk mengakui bahwa mereka telah tumbuh lebih kuat daripada hampir semua negara bangsa di dunia, dan mereka telah mengkonsolidasikan jumlah yang luar biasa dari tidak hanya kekuatan ekonomi, tetapi juga kekuatan politik,” kata Hao. “Mereka terraforming bumi. Mereka mengubah geopolitik kita, seluruh hidup kita. Maka kamu hanya bisa menggambarkannya sebagai kerajaan.”

Openai telah menggambarkan AGI sebagai “sistem yang sangat otonom yang mengungguli manusia pada pekerjaan yang paling berharga secara ekonomi,” yang entah bagaimana akan “mengangkat kemanusiaan dengan meningkatkan kelimpahan, turbocharging ekonomi, dan membantu dalam penemuan pengetahuan ilmiah baru yang mengubah batas kemungkinan.”

Janji -janji samar -samar ini telah memicu pertumbuhan eksponensial industri – tuntutan sumber dayanya yang besar, lautan data yang dikikis, jaringan energi yang tegang, dan kemauan untuk melepaskan sistem yang belum diuji ke dunia. Semua melayani masa depan yang dikatakan banyak ahli mungkin tidak akan pernah tiba.

Acara TechCrunch

San Francisco

|

27-29 Oktober 2025

Hao mengatakan jalan ini tidak dapat dihindari, dan bahwa penskalaan bukan satu -satunya cara untuk mendapatkan lebih banyak kemajuan di AI.

“Anda juga dapat mengembangkan teknik baru dalam algoritma,” katanya. “Anda dapat meningkatkan algoritma yang ada untuk mengurangi jumlah data dan menghitung yang perlu mereka gunakan.”

Tapi taktik itu akan berarti mengorbankan kecepatan.

“Ketika Anda mendefinisikan pencarian untuk membangun AGI yang bermanfaat sebagai salah satu di mana pemenang mengambil semua – yang dilakukan Openai – maka hal yang paling penting adalah kecepatan yang lain,” kata Hao. “Kecepatan lebih dari efisiensi, kecepatan lebih dari keamanan, kecepatan lebih dari penelitian eksplorasi.”

Untuk Openai, katanya, cara terbaik untuk menjamin kecepatan adalah dengan mengambil teknik yang ada dan “lakukan saja hal yang murah secara intelektual, yaitu memompa lebih banyak data, lebih banyak superkomputer, ke dalam teknik yang ada.”

Openai mengatur panggung, dan bukannya tertinggal, perusahaan teknologi lain memutuskan untuk mengantre.

“Dan karena industri AI telah berhasil menangkap sebagian besar peneliti AI top di dunia, dan para peneliti itu tidak lagi ada di dunia akademis, maka Anda memiliki seluruh disiplin yang sekarang dibentuk oleh agenda perusahaan -perusahaan ini, bukan oleh eksplorasi ilmiah yang nyata,” kata Hao.

Pengeluaran telah, dan akan menjadi, astronomi. Pekan lalu, Openai mengatakan mereka berharap untuk terbakar $ 115 miliar dalam bentuk tunai Pada tahun 2029. Meta mengatakan pada bulan Juli bahwa mereka akan menghabiskan hingga $ 72 miliar untuk membangun infrastruktur AI tahun ini. Google berharap untuk mencapai hingga $ 85 miliar Dalam pengeluaran modal untuk tahun 2025, yang sebagian besar akan dihabiskan untuk memperluas infrastruktur AI dan cloud.

Sementara itu, tiang gawang terus bergerak, dan “manfaat bagi kemanusiaan” yang terwujud belum terwujud, bahkan ketika bahaya meningkat. Membahayakan seperti kehilangan pekerjaan, konsentrasi kekayaan, dan chatbot AI yang memicu delusi dan psikosis. Dalam bukunya, Hao juga mendokumentasikan pekerja di negara -negara berkembang seperti Kenya dan Venezuela yang terpapar konten yang mengganggu, termasuk materi pelecehan seksual anak, dan dibayar upah yang sangat rendah – sekitar $ 1 hingga $ 2 per jam – dalam peran seperti moderasi konten dan pelabelan data.

Hao mengatakan itu adalah tradeoff palsu untuk mengadu kemajuan AI melawan kerugian saat ini, terutama ketika bentuk -bentuk AI lainnya menawarkan manfaat nyata.

Dia menunjuk ke Google Deepmind’s Nobel yang memenangkan Alphafold, yang dilatih pada data urutan asam amino dan struktur lipatan protein yang kompleks, dan sekarang dapat secara akurat memprediksi struktur 3D protein dari asam amino mereka-sangat berguna untuk penemuan obat dan memahami penyakit.

“Itu adalah jenis sistem AI yang kita butuhkan,” kata Hao. “Alphafold tidak menciptakan krisis kesehatan mental pada orang. Alphafold tidak menyebabkan kerugian lingkungan yang kolosal … karena dilatih pada infrastruktur yang jauh lebih sedikit. Ini tidak menciptakan kerusakan moderasi konten karena (set data tidak memiliki) semua omong kosong beracun yang Anda hembuskan ketika Anda menggores internet.”

Bersamaan dengan komitmen semu-religius untuk AGI telah menjadi narasi tentang pentingnya balapan untuk mengalahkan Cina dalam ras AI, sehingga Lembah Silikon dapat memiliki efek liberalisasi pada dunia.

“Secara harfiah, yang sebaliknya telah terjadi,” kata Hao. “Kesenjangan itu terus menutup antara AS dan Cina, dan Silicon Valley telah memiliki efek yang tidak liberalisasi pada dunia … dan satu -satunya aktor yang keluar darinya tanpa cedera, Anda bisa berdebat, adalah Silicon Valley sendiri.”

Tentu saja, banyak yang akan berpendapat bahwa Openai dan perusahaan AI lainnya telah menguntungkan kemanusiaan dengan merilis chatgpt dan model bahasa besar lainnya, yang menjanjikan keuntungan besar dalam produktivitas dengan mengotomatiskan tugas-tugas seperti pengkodean, penulisan, penelitian, dukungan pelanggan, dan tugas kerja-kerja lainnya.

Tetapi cara openai terstruktur-sebagian nirlaba, bagian nirlaba-memperumit bagaimana ia mendefinisikan dan mengukur dampaknya pada kemanusiaan. Dan itu lebih rumit oleh berita minggu ini bahwa Openai mencapai kesepakatan dengan Microsoft yang membawanya lebih dekat untuk akhirnya go public.

Dua mantan peneliti Openai Safety mengatakan kepada TechCrunch bahwa mereka khawatir laboratorium AI telah mulai membingungkan misi nirlaba dan nirlaba-bahwa karena orang menikmati menggunakan chatgpt dan produk lain yang dibangun di LLMS, ini mencentang kotak kemanusiaan yang menguntungkan.

Hao menggemakan kekhawatiran ini, menggambarkan bahaya dikonsumsi oleh misi sehingga kenyataan diabaikan.

“Bahkan ketika bukti terakumulasi bahwa apa yang mereka bangun sebenarnya merusak sejumlah besar orang, misi terus membuat semua itu berakhir,” kata Hao. “Ada sesuatu yang sangat berbahaya dan gelap tentang itu, dari (menjadi) yang terbungkus dalam sistem kepercayaan yang kamu bangun sehingga kamu kehilangan kontak dengan kenyataan.”