Para peneliti di Deepseek pada hari Senin merilis model eksperimental baru yang disebut v3.2-exp, yang dirancang untuk secara dramatis lebih rendah biaya inferensi ketika digunakan dalam operasi konteks panjang. Deepseek mengumumkan modelnya Pos di Wajah Memelukjuga memposting makalah akademik terkait di GitHub.

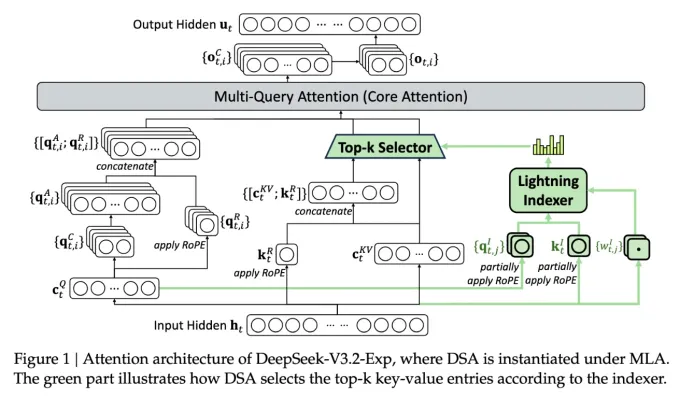

Fitur terpenting dari model baru ini disebut Deepseek Jarang Perhatian, sistem rumit yang dijelaskan secara rinci dalam diagram di bawah ini. Intinya, sistem menggunakan modul yang disebut “pengindeks petir” untuk memprioritaskan kutipan spesifik dari jendela konteks. Setelah itu, sistem terpisah yang disebut “sistem seleksi token berbutir halus” memilih token spesifik dari dalam kutipan tersebut untuk dimuat ke jendela perhatian terbatas modul. Secara keseluruhan, mereka memungkinkan model perhatian yang jarang beroperasi dalam porsi konteks yang panjang dengan beban server yang relatif kecil.

Untuk operasi konteks lama, manfaat sistem ini signifikan. Pengujian pendahuluan oleh Deepseek menemukan bahwa harga panggilan API sederhana dapat dikurangi sebanyak setengah dalam situasi konteks panjang. Pengujian lebih lanjut akan diminta untuk membangun penilaian yang lebih kuat, tetapi karena modelnya terbuka dan tersedia secara bebas untuk memeluk wajah, itu tidak akan lama sebelum tes pihak ketiga dapat menilai klaim yang dibuat di koran.

Model baru Deepseek adalah salah satu serangkaian terobosan baru-baru ini yang mengatasi masalah biaya inferensi-pada dasarnya, biaya server untuk mengoperasikan model AI pra-terlatih, sebagai berbeda dari biaya pelatihannya. Dalam kasus Deepseek, para peneliti mencari cara untuk membuat arsitektur transformator mendasar beroperasi lebih efisien – dan menemukan bahwa ada perbaikan yang signifikan untuk dilakukan.

Berbasis di Cina, Deepseek telah menjadi tokoh yang tidak biasa dalam ledakan AI, terutama bagi mereka yang memandang penelitian AI sebagai perjuangan nasionalis antara AS dan Cina. Perusahaan membuat gelombang pada awal tahun dengan model R1, dilatih terutama menggunakan pembelajaran penguatan dengan biaya yang jauh lebih rendah daripada pesaing Amerika. Tetapi model ini belum memicu revolusi grosir dalam pelatihan AI, seperti yang diperkirakan beberapa orang, dan perusahaan telah surut dari sorotan dalam beberapa bulan sejak itu.

Pendekatan “perhatian jarang” yang baru tidak mungkin menghasilkan keributan yang sama dengan R1 – tetapi masih bisa mengajarkan kami beberapa trik yang sangat dibutuhkan untuk membantu menjaga biaya inferensi tetap rendah.