Para peneliti telah menemukan bahwa sementara chatbots AI seperti chatgpt dapat mendeteksi metafora dalam pidato politik dengan keberhasilan sedang, mereka sering salah menafsirkan bahasa figuratif dalam pidato Donald Trump dan tidak memiliki pemahaman yang bernuansa yang dimiliki manusia.

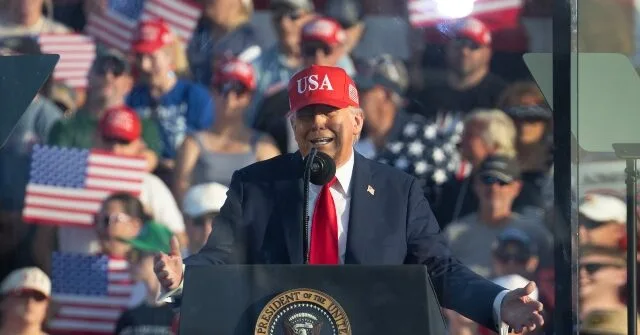

Psypost Laporan bahwa sebuah studi terbaru yang diterbitkan di Perbatasan dalam Psikologi telah menjelaskan kemampuan dan keterbatasan sistem AI dalam hal pemahaman metafora dalam konteks politik. Para peneliti menggunakan pidato Presiden Donald Trump sebagai tempat pengujian untuk ChatGPT- 4, version bahasa besar (LLM) yang dilatih untuk memahami dan menghasilkan bahasa manusia.

Studi ini menganalisis empat pidato Trump dari pertengahan 2010 hingga awal 2025, dengan total lebih dari 28 000 kata. Pidato -pidato ini dipilih untuk penggunaan gaya merek dagang Trump menggunakan metafora untuk membingkai masalah politik dengan cara yang beresonansi dengan pendengar.

Menggunakan metode yang disebut analisis metafora kritis, para peneliti mendorong ChatGPT- 4 untuk mengidentifikasi metafora potensial, mengkategorikannya berdasarkan tema, dan menjelaskan kemungkinan dampak emosional atau ideologis mereka. Model ini mampu mendeteksi metafora dengan tingkat akurasi sekitar 86 persen, mengidentifikasi dengan benar 119 dari 138 kalimat sampel.

Namun, pemeriksaan yang lebih dekat mengungkapkan beberapa masalah berulang dalam penalaran design. ChatGPT- 4 sering membingungkan metafora dengan bentuk ekspresi lain, seperti perumpamaan, dan cenderung menganalisis ekspresi sederhana secara berlebihan. Ia juga berjuang untuk mengklasifikasikan nama dan istilah teknis dengan benar, memperlakukan mereka sebagai metafora alih -alih kata benda yang tepat.

Salah langkah ini menyoroti keterbatasan AI dalam memahami makna dalam konteks. Tidak seperti manusia, LLM tidak mengacu pada pengalaman hidup, pengetahuan budaya, atau nuansa emosional untuk memahami bahasa, yang menjadi sangat jelas ketika menganalisis retorika politik.

Studi ini juga menguji kemampuan ChatGPT- 4 untuk mengkategorikan metafora berdasarkan tema bersama atau “domain sumber,” seperti gerakan dan arah atau kesehatan dan penyakit. Sementara design berkinerja baik dengan tipe metafora yang akrab dan sering digunakan, itu kurang dapat diandalkan dalam kategori yang kurang umum atau lebih abstrak, seperti memasak dan makanan.

Para peneliti membandingkan hasil yang dihasilkan AI dengan yang diproduksi oleh alat analisis metafora tradisional, menemukan bahwa chatgpt lebih cepat dan lebih mudah digunakan tetapi kurang konsisten dalam mengidentifikasi metafora di semua kategori. Mereka juga mencatat bahwa kinerja model sangat tergantung pada bagaimana petunjuk ditulis, dengan perubahan kecil dalam pertanyaan yang mempengaruhi output.

Selain itu, penelitian ini menemukan masalah struktural yang lebih luas dalam bagaimana LLM dilatih. Model -version ini mengandalkan kumpulan data besar yang dikikis dari web, yang mungkin kurang paparan bahasa metaforis dalam konteks budaya, historis, atau politik tertentu. Akibatnya, LLMS dapat mengambil dan mereproduksi predisposition yang ada terkait dengan jenis kelamin, ras, atau ideologi.

Para peneliti menyimpulkan bahwa sementara version bahasa besar menunjukkan janji dalam menganalisis metafora, mereka jauh dari menggantikan keahlian manusia. Kecenderungan mereka untuk salah menafsirkan, melampaui batas, atau kehilangan seluk -beluk membuat mereka paling cocok untuk membantu para peneliti daripada melakukan analisis sepenuhnya otomatis.

Baca lebih lanjut di Psypost di sini.

Lucas Nolan adalah reporter untuk Breitbart Information yang mencakup masalah kebebasan berbicara dan sensing unit online.