Seorang anak laki-laki berusia 14 tahun secara misterius menghilang tanpa jejak dari kamp Pramuka, tidak pernah terlihat lagi – keluarganya hancur.

Tiga minggu kemudian, remaja tersebut, Eric Langford, dinyatakan meninggal setelah polisi yang kebingungan gagal menemukan petunjuk apa pun meskipun telah dilakukan pencarian besar-besaran.

Ajaibnya, Eric tersandung ke kantor polisi 12 tahun kemudian, bertelanjang dada, bertelanjang kaki dan dengan rambut panjang kusut, memohon bantuan – semuanya terekam dalam rekaman keamanan.

Eric memberi tahu mereka bahwa dia diculik dan ditahan di kabin terpencil sampai dia melarikan diri, dan sekarang dapat berkumpul kembali dengan keluarganya.

Jika kisah mencekam seperti itu tampak terlalu bagus untuk menjadi kenyataan, itu memang benar adanya.

Eric tidak pernah diculik, tidak pernah mengikuti perkemahan Pramuka di Pegunungan Adirondack di New York, dan bahkan tidak pernah ada.

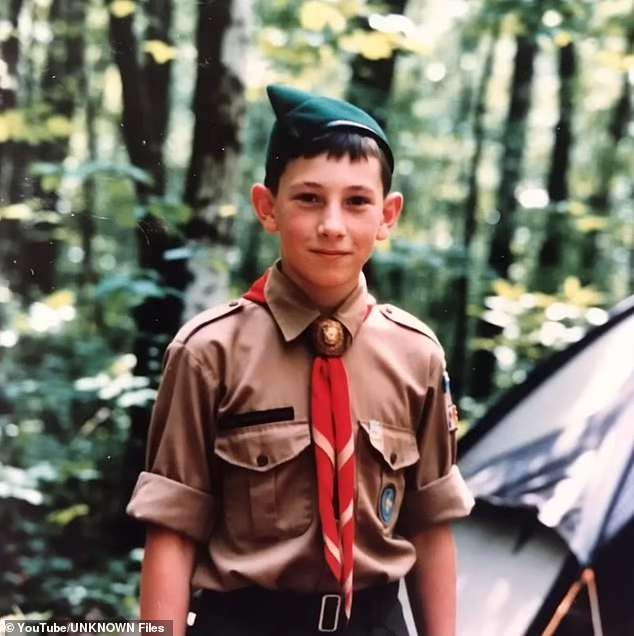

Keseluruhan cerita – termasuk foto seorang anak laki-laki yang hilang secara tragis dalam seragam pramuka dan rekaman kantor polisi yang mengejutkan – dibuat dengan AI.

Para ahli mengatakan kepada Daily Mail bahwa meskipun cerita palsu seperti ini bukanlah hal baru, AI membuatnya lebih mudah untuk diproduksi secara massal dan lebih dapat dipercaya oleh pemirsa yang tidak menaruh curiga, dan memperingatkan akan adanya masa depan yang menakutkan dari misinformasi yang merajalela.

Gambar Pramuka fiksi Eric Langford, 14, yang dibuat oleh AI, yang menurut cerita hoax menghilang dari sebuah kamp di bagian utara New York pada tahun 1989

“Dalam waktu dekat, contoh Pramuka Palsu akan menjadi sebuah norma,” kata konsultan media sosial FGS Global, Willie Roberson.

‘Orang-orang tidak akan tahu apakah sesuatu tentang orang, koneksi, masalah, dan/atau aktivitas yang mereka lakukan itu nyata atau tidak, tapi hal itu ada di feed mereka karena algoritmanya.

“Mereka juga tidak memiliki keterampilan literasi media yang kritis dan kemampuan untuk membedakan apakah hal tersebut nyata atau tidak.”

Tipuan Eric Langford dimulai dengan video berdurasi 28 menit di saluran YouTube ‘Unknown Files’, yang menampilkan dirinya hanya sebagai podcast kejahatan nyata.

‘Kami bercerita tentang penghilangan misterius, investigasi rumit, dan nasib tak terduga. Selami kisah kehidupan nyata yang penuh drama, misteri, dan emosi manusia,’ demikian bunyi deskripsinya.

Namun, semua video saluran memiliki format yang sama – suara buatan yang menceritakan kisah melalui gambar subjek yang dihasilkan AI.

Setiap video bercerita tentang seseorang yang menghilang saat mendaki atau di kawasan hutan belantara, namun secara ajaib muncul beberapa tahun kemudian.

Video Eric Langford kemudian dipotong menjadi enam klip seukuran gigitan dan diposting di TikTok oleh pengguna lain, mengumpulkan jutaan penayangan di antaranya.

Semua klip ini dimulai dengan sudut yang sedikit berbeda dari rekaman kamera keamanan yang diduga berasal dari kantor polisi di Albany, New York, tempat Eric tersandung.

Setiap cuplikan menunjukkan Eric yang kurus dengan rambut panjang kusut dan janggut perlahan masuk dan memohon bantuan kepada petugas di resepsi.

Rekaman tersebut hanya berdurasi sekitar sepuluh detik, yang merupakan batas untuk video yang dihasilkan AI di banyak platform pembuatan, sebelum kembali ke latar belakang File Tidak Dikenal.

Ajaibnya, Eric tersandung ke kantor polisi 12 tahun kemudian, bertelanjang dada, bertelanjang kaki dan dengan rambut panjang kusut, memohon bantuan – semuanya terekam dalam rekaman keamanan. Tapi semuanya dipalsukan dengan AI

Cerita berlanjut bahwa Eric berada di kamp Pramuka di Black Pond, sebuah jalur danau berhutan terpencil di Pegunungan Adirondack di bagian utara New York.

Pasukan pramuka yang dipimpin oleh instruktur David Harrison memulai pendakian malam tradisional mereka pada tanggal 17 Juli 1989, dan berencana mendirikan kemah untuk malam itu.

Eric mengajukan diri untuk mengambil air dari sungai terdekat, tapi tidak pernah kembali.

Deputi Sheriff Essex County melakukan pencarian dalam radius 50 mil dari kamp sebanyak dua kali, namun tidak menemukan jejak remaja tersebut dan dia dinyatakan meninggal tiga minggu kemudian.

Orang tuanya berduka dan dunia terus berjalan tanpa dia – hingga 3 Oktober 2001, ketika dia tersandung ke kantor polisi.

Eric mengklaim seorang pria bernama Charles Daniels menculiknya dan menahannya di sel ruang bawah tanah kedap suara di sebuah pondok berburu terpencil selama 12 tahun.

Daniels rupanya meyakinkan bocah itu bahwa dunia telah dilanda perang dan orang tuanya telah meninggal.

Dia melarikan diri ketika Daniels terkena stroke, dan polisi melacak predator tersebut di rumah sakit – tetapi dia meninggal empat hari kemudian tanpa mengatakan apa pun tentang kejahatan tersebut.

Video tersebut diakhiri dengan prediksi suram tentang masa depan Eric saat ia memasuki kembali masyarakat sebagai pria berusia 26 tahun yang dilupakan oleh dunia.

‘Tetapi bagi Eric sendiri, itu bukanlah sebuah cerita. Sudah 12 tahun hidupnya yang tidak akan pernah bisa dikembalikan. Itu adalah masa kecil yang dicuri oleh seorang pria yang motifnya masih menjadi misteri,’ kata sulih suara AI.

‘Ini adalah perjuangan sehari-hari dengan kenangan yang tidak dapat dihapus oleh waktu, dan ini adalah pengingat bahwa terkadang monster tidak hidup dalam dongeng, tetapi jauh di dalam hutan, di rumah-rumah tua yang tidak dapat dijangkau oleh jalan raya.

‘Dan penghilangan tersebut tidak selalu merupakan akhir, namun terkadang merupakan awal dari mimpi buruk terburuk yang dapat berlangsung selama bertahun-tahun.’

Tipuan Eric Langford dimulai dengan video berdurasi 28 menit di saluran YouTube ‘Unknown Files’, yang menampilkan dirinya hanya sebagai podcast kejahatan nyata (thumbnail video dalam gambar)

Hal yang menarik seperti itu akan menjadi bahan pembicaraan bagi setiap surat kabar tabloid dan acara TV di AS, semuanya berlomba untuk menjadi orang pertama yang mewawancarai Eric dan melacak kabin tempat dia ditahan.

Lagi pula, saat narasi video dimulai, ‘Apa yang dia katakan kepada penyelidik mengungkap salah satu kisah penculikan paling mengerikan dalam sejarah kriminal Amerika.’

Namun tidak ada satu pun referensi tentang Eric atau kisahnya yang dapat ditemukan di arsip surat kabar, dan tidak dilaporkan di situs web mana pun yang dapat diandalkan.

Beberapa detailnya juga tidak sesuai dengan kenyataan, seperti Eric yang diumumkan setelah tiga minggu, padahal undang-undang New York mengharuskan setidaknya tiga tahun.

Hal ini tidak menghentikan berita tersebut untuk diposkan ulang dan dimuntahkan oleh halaman media sosial dan situs web yang mencurigakan – beberapa di antaranya berbasis di Vietnam – yang semuanya tampaknya menggunakan AI.

Meskipun kisah Eric Langford menjadi viral di media sosial dan ribuan orang mem-posting ulang kisah tersebut sebagai kisah nyata, namun kisah tersebut hanyalah salah satu dari banyak pemalsuan AI yang membanjiri internet.

Situs penyangkalan hoax, Snopes, memiliki lusinan cerita palsu serupa yang dihasilkan oleh AI yang telah diselidiki dan ternyata palsu.

“Kebohongan yang disebabkan oleh AI sedang meningkat terutama karena teknologi telah mempermudah pembuatan dan pendistribusiannya sekaligus menghilangkan banyak titik gesekan yang mungkin memperlambat disinformasi,” kata pengacara cedera Joe Zdrilich kepada Daily Mail.

‘Cerita-cerita seperti ini tampaknya masuk akal karena mengikuti pola-pola emosional yang sudah ada, menggunakan detail-detail yang sesuai dengan sejarah, dan dieksekusi dengan tingkat kehalusan tertentu.’

Setiap cuplikan menunjukkan Eric yang kurus dengan rambut panjang kusut dan janggut perlahan masuk dan memohon bantuan kepada petugas di resepsi.

Profesor Universitas George Washington dan mantan pejabat Badan Keamanan Siber dan Infrastruktur AS, Anmol Agarwal, mengatakan meskipun cerita Eric Langford hanya dibuat untuk menghasilkan uang dari klik, cerita lain memiliki motif jahat.

“Seringkali postingan/artikel misinformasi ini mencoba membentuk opini publik mengenai suatu isu, sehingga untuk itu mereka mencoba menyasar emosi,” ujarnya.

“Kampanye misinformasi dipicu oleh emosi manusia seperti kepanikan, urgensi, dan biasanya terlihat sangat sensasional, sehingga dapat disebarkan dan disebarkan dengan cepat.

‘Model AI menjadi lebih canggih dan lebih mudah bagi orang-orang untuk menghasilkan gambar, video, dan konten yang tampak sangat realistis dengan cepat dan mudah, dan ada banyak alat yang dapat melakukan hal ini untuk orang-orang yang sepenuhnya gratis.’

Konsultan TI Nizel Adams mengatakan dia menangani AI palsu ‘setiap hari’, dibuat dapat dipercaya dengan menggunakan struktur dan kata-kata yang sama dengan yang asli.

‘Ada ratusan bahkan ribuan situs berita palsu yang menghasilkan lusinan artikel palsu setiap hari dengan merayapi situs berita sah dan kemudian membuat konten berdasarkan artikel tersebut,’ katanya.

“Kadang-kadang, kita akan melihat pengulangan cerita viral yang dihasilkan oleh AI yang diterbitkan beberapa tahun lalu oleh sumber berita yang sah, namun cerita di balik gambar tersebut sama sekali berbeda dari aslinya.

‘Apa yang tadinya merupakan berita yang menyenangkan, diubah menjadi sesuatu yang berbeda dengan konteks yang asing.’

Pakar AI Qualaix Marva Bailer mengatakan cerita Eric adalah contoh ‘fase baru misinformasi’ yang didasarkan pada penceritaan emosional agar tampak nyata.

‘Strukturnya mencerminkan jurnalisme kepentingan manusia. Seorang anak yang hilang. Garis waktu yang panjang. Sebuah resolusi yang dramatis. Bukti visual berlapis-lapis,’ katanya.

‘Setiap elemen meningkatkan kepercayaan dan berbagi. Ini adalah cerita yang direkayasa secara emosional yang dibuat agar terasa nyata, menyebar dengan cepat, dan mendapatkan kepercayaan.’

Matthew Stern, penyelidik swasta kejahatan dunia maya di perusahaannya CNC Intelligence, mengatakan bahwa hoaks AI ditulis, terstruktur, dan didistribusikan dengan cara yang sangat mirip dengan pelaporan sah atau kesaksian pribadi.

‘Hal ini membuat mereka dapat dipercaya dan sulit untuk dibantah tanpa penelitian mendalam, sesuatu yang mungkin tidak dapat dilakukan oleh pembaca pada umumnya,’ katanya.

‘Narasi yang dihasilkan AI kini memenuhi banyak sinyal di tingkat permukaan yang secara historis kita andalkan untuk menilai legitimasi.’

Pendiri StarApple AI Adrian Dunkley memperingatkan bahwa ketika orang berhenti bertanya apakah sesuatu itu benar, manipulasi menjadi mudah.

“Pembongkaran tidak bisa mengimbangi penipuan skala industri yang menjadi tujuan AI,” katanya.

Para ahli memperingatkan bahwa misinformasi akan menjadi begitu merajalela sehingga akan sangat merusak kepercayaan terhadap media yang sah.

Rangkaian komentar di media sosial sudah penuh dengan orang-orang yang menuduh video dramatis apa pun sebagai AI, tidak peduli keabsahannya.

“Ketika konten yang dibuat oleh AI menjadi tidak dapat dibedakan dari konten yang dibuat oleh manusia dan dimuat di situs berita yang sah, konsumen tidak tahu berita mana yang nyata dan mana yang tidak,” kata Stern.

‘Hal ini pada akhirnya dapat menyebabkan runtuhnya kredibilitas, dan bahkan informasi yang akurat pun tidak tersedia secara fungsional.’

Zdrilich mengatakan dari sudut pandangnya sebagai pengacara, AI membuat lebih sedikit orang mempercayai kesaksian korban sebenarnya dan bahkan memverifikasi catatan publik.

“Hilangnya kepercayaan ini juga mempunyai implikasi hukum dan sosial, mulai dari pelecehan terhadap orang yang tidak bersalah hingga kemarahan publik yang salah arah,” katanya.

Bailer mendorong pembaca untuk mewaspadai cerita apa pun yang tampaknya dirancang untuk memancing respons emosional.

“Kisah-kisah yang mendorong urgensi, nostalgia, atau simpati mendalam patut dihentikan sementara,” katanya.

‘Memeriksa sumber asli, memverifikasi gambar, dan mengonfirmasi liputan oleh outlet yang sudah mapan membantu mengurangi paparan terhadap manipulasi.’