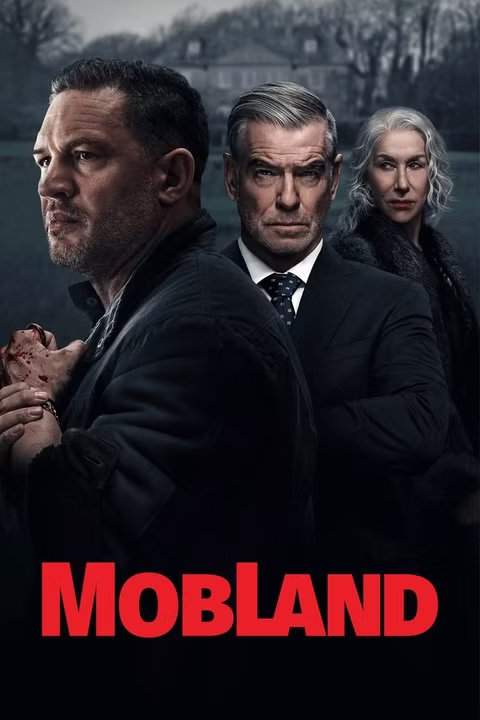

Tom Hardy Serial thriller kriminal yang menegangkan terus mendominasi kompetisi streaming menjelang hadirnya musim terbarunya. Awal tahun ini, Hardy bekerja sama dengan Pierce Brosnan Dan Helen Mirren untuk Tanah Massa acara yang mengikuti seorang pemecah masalah yang terjebak di tengah dua keluarga kejahatan terorganisir yang bertikai. Tanah Massa diperbarui untuk musim kedua, dan dengan produksi yang akan dimulai pada Musim 2 kapan saja, acara ini kembali masuk 10 besar Paramount+ secara worldwide. Dengan kesuksesan streaming yang berkelanjutan, sulit untuk tidak berpikir bahwa Musim 2 memiliki peluang untuk menjadi lebih besar daripada Musim 1

Tanah Massa ditulis dan dibuat untuk television oleh Ronan Bennett dengan Teman Richie menjabat sebagai sutradara dan produser terkemuka di acara itu. Dilaporkan bahwa dia sangat terlibat dalam arahan kreatif acara tersebut. Tidak butuh waktu lama Tanah Massa lama setelah penayangan perdananya untuk membuat perbandingan Raja Tulsa acara thriller kriminal menegangkan lainnya dari Taylor Sheridan yang juga ada di Paramount+. Meskipun premis keduanya berbeda, penggemar yang satu kemungkinan besar juga akan menjadi penggemar yang lain.

Ini merupakan tahun yang besar bagi Tom Hardy, terlebih lagi jika Anda memperpanjang tahun itu hingga bulan-bulan terakhir tahun 2024 Hardy memerankan Eddie Brock untuk yang mungkin merupakan kali terakhirnya dalam movie tersebut. Racun: Tarian Terakhir aksi struck lainnya yang juga menjadi kesuksesan streaming besar di Netflix dalam beberapa bulan sejak debutnya. Sebelum Tanah Massa tiba di Paramount+, Hardy membintangi movie aksi orisinal Netflix yang mendapat sorotan kritis, Malapetaka yang menduduki puncak tangga lagu streaming selama berbulan-bulan meskipun penerimaannya kurang baik. Dia juga sedang mengerjakan beberapa proyek menarik, tetapi tidak ada satupun yang memiliki tanggal rilis pasti.

Kapan MobLand Musim 2 Keluar?

Tanah Massa Musim 2 tidak memiliki tanggal rilis resmi, tetapi acara tersebut diperkirakan akan kembali sebelum akhir tahun depan. Joanne Froggatt mengkonfirmasi bahwa produksi Musim 2 dijadwalkan akan dimulai pada akhir Oktober, dan meskipun tidak ada indikasi bahwa tim produksi dapat mematuhi jadwal ini, ini masih merupakan pertanda baik bahwa segala sesuatunya akan berjalan secepat ini. Jika Tanah Massa menyelesaikan syuting sebelum tahun 2026 berakhir, itu sangat mungkin acara tersebut mungkin akan mendapatkan tanggal rilis sekitar waktu ini tahun depan

Pantau terus Collider untuk pembaruan dan liputan lebih lanjut Tanah Massa Musim 2, dan tonton musim pertama di Paramount+.

- Tanggal Rilis

-

30 Maret 2025

- Jaringan

-

Yang terpenting+.

- Direktur

-

Daniel Syrkin.

-

-

Pierce Brosnan

Conrad Harrigan.